Openapi donne des super-pouvoirs aux API grâce au MCP

Model Context Protocol : un guide complet sur son fonctionnement et comment OpenAPI l'utilise pour des API encore plus accessibles.

Le Model Context Protocol (MCP) est la nouvelle tendance dans le monde de la tech — et pas seulement. Tout le monde en parle : il apparaît dans les dépôts GitHub, les vidéos YouTube et devient un sujet central lors de nombreux événements. Mais qu’est-ce que le MCP exactement, et pourquoi pourrait-il vraiment révolutionner le secteur de l’intelligence artificielle ?

Qu’est-ce que le Model Context Protocol (MCP) ?

Le Model Context Protocol est un protocole open-source et open standard lancé par Anthropic en novembre 2024, une entreprise de référence dans le domaine de l’IA et concurrente directe d’OpenAI, connue pour ses modèles LLM appelés Claude.

Le sujet MCP a toutefois explosé seulement quelques mois plus tard, début 2025, avec l’attention croissante portée aux agents IA et les déclarations de dirigeants tech de renom comme Sam Altman ou Sundar Pichai sur leur utilisation du protocole.

MCP est né pour résoudre un problème très concret : améliorer la qualité et la pertinence des réponses générées par les grands modèles de langage (LLM), souvent victimes d’un manque de contexte et sujettes à des erreurs ou incohérences (appelées hallucinations).

Le protocole MCP définit une norme universelle permettant aux applications de fournir du contexte aux LLM, facilitant la communication entre les modèles, les applications basées sur l’IA, les écosystèmes de données, les outils métiers et les environnements de développement. Pour cette raison, MCP est souvent comparé à l’USB-C de l’IA.

Comment fonctionne le MCP ?

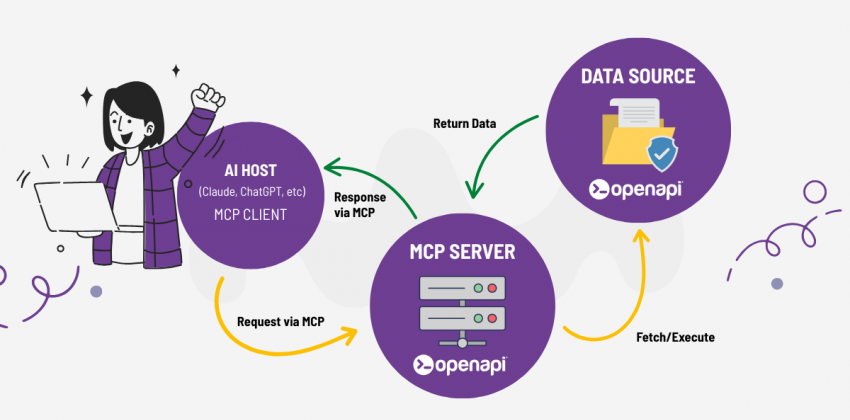

Comme mentionné, MCP est une norme qui permet aux développeurs de créer des connexions entre sources de données et outils IA. Ces outils peuvent exposer leurs données via des serveurs MCP ou créer des applications IA (clients MCP) capables de se connecter à ces serveurs.

MCP repose sur une architecture client-serveur simple et modulaire :

-

LLM : le grand modèle de langage qui interprète les entrées utilisateur et le contexte additionnel.

-

Hôte MCP : l’application qui héberge le LLM.

-

Client MCP : un composant qui maintient des connexions 1:1 avec les serveurs MCP et transmet le contexte au LLM.

-

Serveur MCP : un service qui expose des données, des outils ou des fonctionnalités via MCP.

Le serveur MCP peut accéder en toute sécurité à des fichiers, bases de données ou services en ligne (comme GitHub ou des API externes), et transmettre ces informations dans un format standardisé au client MCP, qui les envoie au LLM pour enrichir le contexte et améliorer la réponse.

Pourquoi le MCP est important pour les développeurs

Avant le MCP, chaque application ou modèle IA devait intégrer chaque source de données ou outil séparément, ce qui représentait un vrai défi d’intégration de type “M×N” (M étant les applications, N les sources). Le MCP simplifie radicalement ce modèle en le transformant en “M+N”, rendant le développement bien plus efficace.

Les développeurs n’auront plus besoin de créer des interfaces spécifiques pour chaque modèle ou source : ils pourront développer des agents et des workflows à un niveau supérieur. Changer de modèle IA ou d’outil deviendra beaucoup plus simple, sans réécriture de code ni dépendance à un fournisseur spécifique.

MCP et API : quelles différences ?

MCP et les API REST peuvent sembler similaires, car tous deux permettent d’interroger des services externes. Mais ils fonctionnent de manière très différente.

Une des grandes différences concerne la façon dont les requêtes sont effectuées et les réponses traitées. Une API REST fonctionne avec des endpoints, des paramètres précis et une réponse structurée, sans possibilité d’interprétation par l’IA.

Le MCP, lui, permet des requêtes via des prompts en langage naturel, tout en fournissant un contexte supplémentaire aux LLM, leur permettant de déterminer quand et pourquoi utiliser un outil, dans une logique orientée objectifs.

Autre différence fondamentale : le MCP est orienté session, ce qui permet aux agents IA de maintenir des dialogues continus et riches en contexte avec les services de backend.

Contrairement aux API REST stateless, MCP gère :

-

Une mémoire de session entre interactions,

-

Des appels structurés d’outils pour des actions complexes,

-

Le streaming via Server-Sent Events (SSE) ou HTTP.

Cependant, comme mentionné, les API peuvent être une composante des outils accessibles via un serveur MCP. Par exemple, lorsqu’un LLM choisit un outil, cela peut impliquer une requête API et la transmission de la réponse à l’IA.

Cas d’usage du MCP : de GitHub à Salesforce, de Postman à Canva

L’adoption du MCP ouvre des opportunités immenses, même en dehors des domaines strictement techniques.

Les développeurs peuvent, par exemple, utiliser des agents IA pour relire ou écrire du code, accéder à des plateformes comme GitHub, détecter des erreurs, déboguer ou automatiser des tâches répétitives.

Mais le potentiel du MCP va bien plus loin : il pourra aussi être utilisé pour la rédaction de contenus techniques, la gestion du support client, ou encore l’accès à des bases documentaires.

Ces dernières semaines, plusieurs entreprises ont annoncé l’intégration du MCP :

-

Salesforce : simplifie l’accès sécurisé aux données CRM via agents IA, sans licence ni formation. Les développeurs peuvent automatiser déploiements, requêtes et tests avec des prompts intelligents dans leur IDE. Les responsables IT profitent d’une gouvernance centralisée pour gérer politiques, accès et permissions sur tous les connecteurs MCP.

-

GitHub : a intégré MCP pour automatiser les tâches liées au code, intégrer des outils contextuels et activer des workflows cloud accessibles depuis n’importe quel appareil.

-

Postman : permet désormais de créer des agents MCP de manière visuelle, sans serveur ni code à héberger. Tout démarre en un clic, avec tests immédiats et intégration possible avec Agent Mode ou autres agents via le support MCP distant.

-

Canva : grâce à l’intégration MCP, il sera bientôt possible de créer et modifier des projets Canva directement depuis une conversation. L’assistant IA pourra générer des présentations, redimensionner, importer ou exporter des ressources — sans quitter le chat.

Comment Openapi implémente le MCP dans ses applications

Nous sommes heureux d’annoncer une évolution importante chez Openapi : notre équipe technique travaille actuellement à la création d’un serveur Openapi basé sur le Model Context Protocol (MCP), l’une des technologies les plus innovantes dans le domaine de l’IA appliquée aux API.

Grâce à cette nouvelle infrastructure, les applications IA pourront interagir en temps réel avec notre bibliothèque d’API, en effectuant des requêtes complexes de manière naturelle, contextuelle et automatisée. Cela signifie qu’il sera possible de :

-

Accéder à plus de 400 services API et à des millions de données via un simple prompt en langage naturel,

-

Générer, filtrer et enrichir des informations dynamiquement,

-

Intégrer des workflows intelligents avec des systèmes externes sans code complexe,

-

Permettre à des agents conversationnels IA de gérer des tâches API de façon autonome.

Le serveur MCP d’Openapi ouvrira la voie à de nouveaux scénarios d’utilisation de nos API, simplifiant leur intégration dans des systèmes IA et accélérant les processus de développement, de test et d’automatisation.

Nous partagerons bientôt plus de détails sur la date de lancement, la documentation technique et les premières intégrations disponibles.